1. La IA ya está en la empresa… y también los datos sensibles

La adopción de IA generativa en las organizaciones está yendo a una velocidad brutal. Algunas empresas la usan de forma “oficial” (por ejemplo con Copilot), y otras muchas la están usando de forma informal sin que seguridad lo vea venir. Pero, en todos los casos, hay un patrón común: la IA necesita contexto, y ese contexto casi siempre son datos.

Y aquí aparece el primer riesgo real: cuando hablamos de IA, tendemos a pensar en el modelo (si es “seguro”, si es “privado”, si está en cloud o en on-prem). Pero en la práctica, el riesgo suele estar en otro sitio: en lo que metemos dentro. Prompts con información interna, documentos que se usan para RAG, datos sensibles que entran en una conversación, o incluso resultados generados que acaban reenviándose o pegándose donde no toca.

Lo más delicado es que este riesgo no siempre se ve. A diferencia de escenarios clásicos (correo, archivos compartidos, endpoints), en IA entran nuevas piezas:

- Prompts: lo que el usuario pregunta o pega.

- Respuestas generadas: que pueden contener datos sensibles sin que nadie lo note.

- Contexto adicional: fuentes conectadas, documentos usados para grounding, bases de conocimiento, etc.

En otras palabras: aunque el usuario no “adjunte” un archivo, puede estar exponiendo información igualmente. Y si no tienes visibilidad, es fácil que la IA se convierta en un canal silencioso de fuga de datos… sin mala intención, simplemente por uso diario.

Por eso, antes incluso de hablar de “seguridad de IA”, conviene hablar de algo más básico: seguridad del dato en escenarios de IA y aquí es donde DSPM for AI puede encajar perfectamente.

2. ¿Qué es DSPM for AI y por qué aparece ahora?

DSPM for AI responde a una pregunta muy sencilla, pero que hasta hace poco no tenía una buena respuesta:

¿qué datos está usando realmente la IA dentro de mi organización?

DSPM viene de Data Security Posture Management, y aplicado a IA significa algo muy concreto: entender, evaluar y reducir el riesgo de los datos que se utilizan en escenarios de inteligencia artificial. No hablamos solo de dónde están los datos, sino de cómo se usan, quién los usa y en qué contexto.

Esto es importante porque la IA introduce una forma completamente nueva de interactuar con la información. Ya no estamos solo ante archivos almacenados o correos enviados. Ahora tenemos:

- Usuarios escribiendo prompts en lenguaje natural

- Sistemas que consultan documentos como contexto

- Modelos que generan respuestas mezclando conocimiento público y datos internos

En este escenario, los controles clásicos se quedan cortos. El DLP tradicional, por ejemplo, está pensado para detectar movimientos de datos muy concretos (un archivo que se adjunta, un correo que se envía, un documento que se comparte). Pero en IA, el dato puede aparecer fragmentado, transformado o implícito dentro de una conversación.

Aquí es donde DSPM for AI marca la diferencia. En lugar de mirar solo el “objeto” (archivo, email, documento), pone el foco en el uso del dato dentro del flujo de IA. Es decir:

- Qué tipo de información entra en un prompt

- Si esa información es sensible o está clasificada

- Si se está usando en un contexto adecuado

Por eso DSPM for AI no aparece como una moda más, sino como una evolución lógica. La IA ya está integrada en el día a día de los usuarios, y necesita controles específicos, pensados para cómo se consume y se expone la información en este nuevo modelo de interacción.

En resumen: DSPM for AI no intenta frenar el uso de la IA, sino hacer visible el riesgo del dato cuando la IA entra en juego.

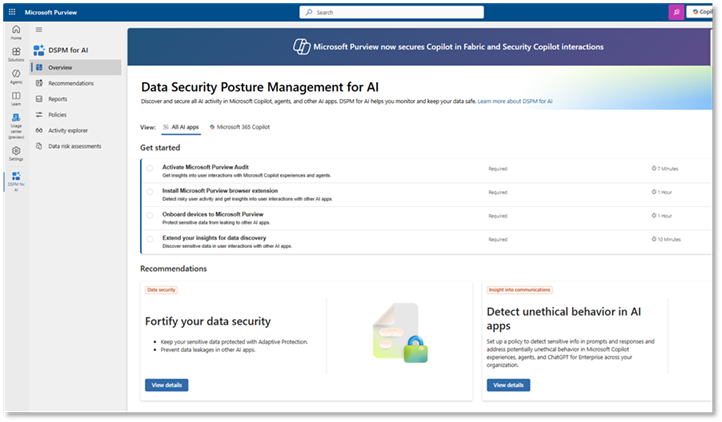

3. DSPM for AI dentro de Microsoft Purview

Para entender DSPM for AI, es importante saber dónde vive y con qué se apoya. En el ecosistema Microsoft, esta capacidad forma parte de Microsoft Purview, la plataforma que centraliza el gobierno, la protección y el cumplimiento del dato.

Purview ya llevaba tiempo ayudando a las organizaciones a clasificar información, aplicar etiquetas de sensibilidad y definir políticas de protección. Lo que cambia con DSPM for AI es que esa inteligencia sobre el dato se conecta directamente con escenarios de IA.

Dicho de forma sencilla:

Purview deja de mirar solo dónde está el dato y empieza a mirar cómo se está usando cuando entra en juego la inteligencia artificial.

Desde aquí, DSPM for AI es capaz de correlacionar distintas señales:

- La sensibilidad del dato (clasificaciones y etiquetas)

- El contexto de uso (por ejemplo, si el dato se utiliza en un prompt o como fuente de conocimiento)

- La identidad del usuario que interactúa con la IA

- El servicio de IA implicado (como Copilot o escenarios basados en modelos generativos)

Esto permite algo que hasta ahora era muy difícil: tener una visión unificada del riesgo del dato en escenarios de IA, sin depender solo de suposiciones o buenas intenciones de los usuarios.

Desde el punto de vista del equipo de seguridad, el valor es claro. En lugar de preguntarse “¿y si alguien pega información sensible en un prompt?”, ahora se puede empezar a responder con datos reales:

- Qué tipo de información se está usando

- En qué contextos

- Y si ese uso encaja o no con las políticas de la organización

En resumen, DSPM for AI convierte a Purview en el punto de control donde datos, identidad e IA se cruzan, algo clave en un escenario donde la IA ya forma parte del trabajo diario.

4. Activando DSPM for AI: requisitos previos y pasos necesarios

Antes de empezar a ver valor con DSPM for AI, hay un paso imprescindible: preparar el entorno. DSPM for AI no funciona de forma aislada, sino que se apoya en distintas señales que ya existen dentro del ecosistema Microsoft. Por eso, hay una serie de requisitos previos que conviene tener claros desde el principio.

El primero es el licenciamiento. DSPM for AI requiere Microsoft 365 E5, ya que utiliza capacidades avanzadas de auditoría, protección de datos y visibilidad que no están disponibles en planes inferiores. Este punto es importante porque marca claramente el tipo de organizaciones a las que va dirigido.

Además, necesitaremos una licencia de Microsoft 365 Copilot en caso de que queramos monitorizar las interacciones de nuestros usuarios mediante este producto.

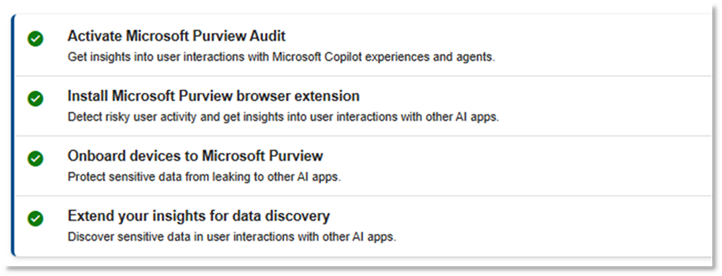

A partir de ahí, es necesario completar varios pasos para que Purview pueda recopilar y correlacionar información relevante en escenarios de IA:

Activar Microsoft Purview Audit

La auditoría es una pieza clave. Permite a Purview recoger eventos relacionados con el uso de aplicaciones, accesos y actividades que luego servirán como base para el análisis de riesgo. Sin esta señal, la visibilidad sería muy limitada. La activación puede durar hasta 24 horas.

Instalar la extensión de navegador de Microsoft Purview

El navegador es uno de los principales puntos de interacción con servicios de IA. La extensión de Purview permite aplicar controles y obtener visibilidad cuando los usuarios acceden a aplicaciones cloud, escriben información o interactúan con servicios de IA desde el browser. Esta activación puede ser hecha a escala, por ejemplo a través de Intune: Introducción a la extensión Microsoft Purview para Chrome | Microsoft Learn

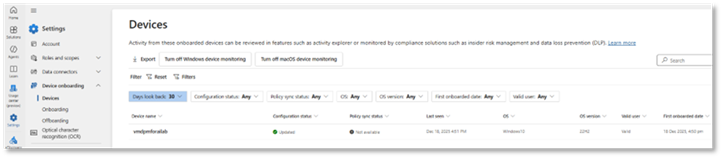

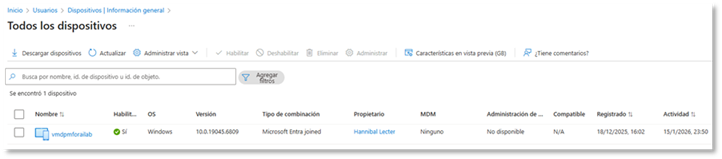

Inscribir dispositivos en Microsoft Purview

Para que las protecciones y la visibilidad funcionen correctamente, los dispositivos deben estar inscritos. Esto permite aplicar políticas de forma coherente y asegurar que las señales recogidas están asociadas a identidades y contextos reales de uso. Si ya hemos unido nuestros dispositivos mediante Defender for Endpoint (MDE) no necesitamos hacer este paso, puesto que la incorporación a MDE también los incorpora a Microsoft Purview y viceversa.

La documentación oficial no exige explícitamente que los dispositivos sean Microsoft Entra ID joined, aunque en muchos escenarios de gestión empresarial (por ejemplo con Intune) esto es una práctica común para aplicar políticas y configuraciones de forma coherente. En mi caso y para la demo, inscribí el dispositivo como Microsoft Entra Joined

Extender la visibilidad para el descubrimiento de datos

Por último, es necesario ampliar la visibilidad de Purview sobre los datos de la organización. Esta opción, conocida como “Extend your insights for data discovery”, permite a DSPM for AI correlacionar el uso de IA con datos clasificados y no clasificados, ofreciendo una visión más completa del riesgo.

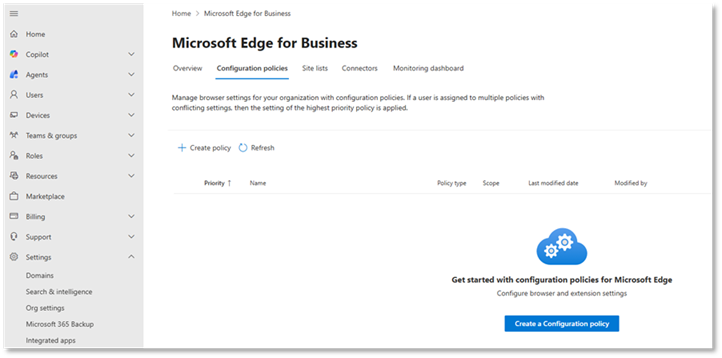

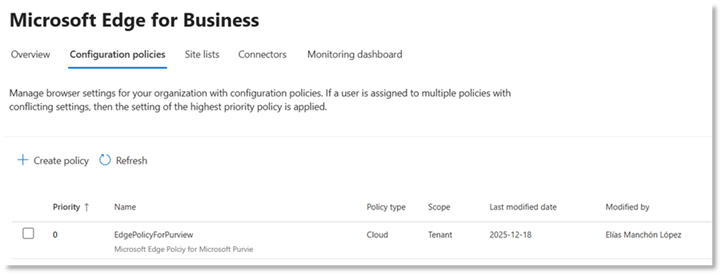

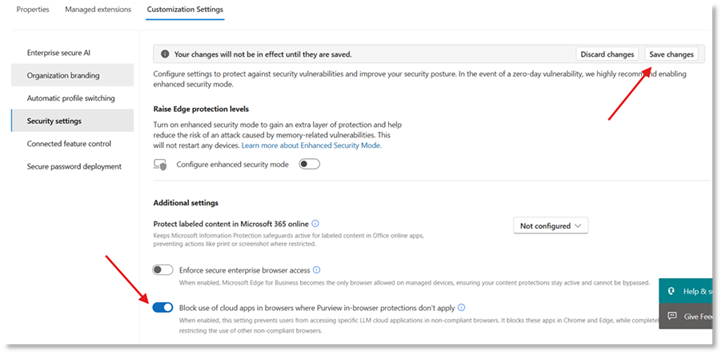

Directiva de configuración de Edge

Por último, es imprescindible configurar una directiva de Microsoft Edge que active las políticas DLP de Purview en el navegador for Business. Esto se hace creando una política de configuración (generalmente a través de Intune/Microsoft 365 Admin Center) y activando la opción que impide usar aplicaciones en la nube desde navegadores donde no se aplican las protecciones de Purview.

Sin esta directiva, las políticas de protección no se harán efectivas en el navegador aun cuando DSPM for AI esté activado

Activación de la directiva DLP en Microsoft Edge | Microsoft Learn

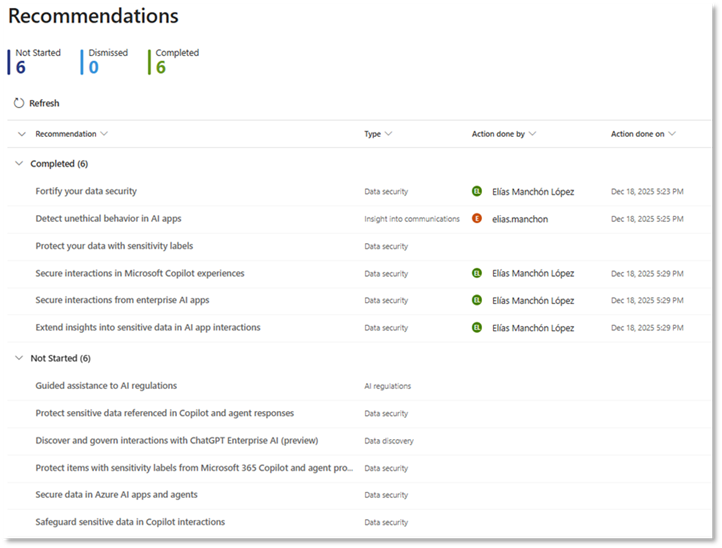

5. Mejorar la postura de seguridad con DSPM for AI: del diagnóstico a la acción

Una vez activado DSPM for AI, uno de los elementos más útiles —y a veces menos comentados— es su panel de recomendaciones. Este panel no se limita a mostrar información, sino que actúa como una especie de hoja de ruta para mejorar la postura de seguridad de los datos en escenarios de IA.

DSPM for AI analiza las señales disponibles (datos, identidades, uso de IA, configuraciones existentes) y las traduce en recomendaciones accionables. No habla en términos abstractos, sino en acciones concretas que ayudan a reducir riesgo real.

Algunos ejemplos habituales de este tipo de recomendaciones son:

- Refuerza la seguridad de tus datos

- Detecta comportamiento no éticos en aplicaciones de IA.

- Asegura las interacciones en experiencias de Microsoft Copilot

- …

El valor de este enfoque es que no obliga a saberlo todo desde el primer día. DSPM for AI asume que muchas organizaciones están en un punto intermedio y propone mejoras progresivas, priorizadas por impacto.

Desde el punto de vista del equipo de seguridad, esto cambia bastante la forma de trabajar. En lugar de preguntarse “¿por dónde empiezo?”, el panel de DSPM for AI ayuda a:

- Identificar lagunas reales en la protección

- Priorizar acciones con mayor retorno en seguridad

- Evolucionar desde visibilidad hacia control, paso a paso

En la práctica, DSPM for AI no solo muestra riesgos: ayuda a construir una postura de seguridad más madura para el uso de IA, alineando datos, identidades y controles.

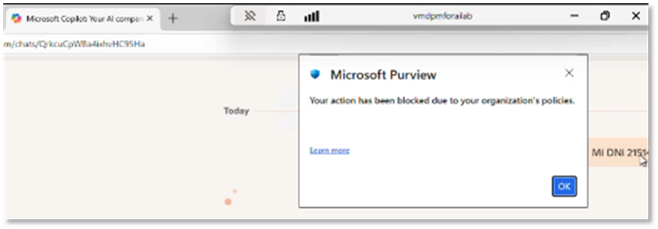

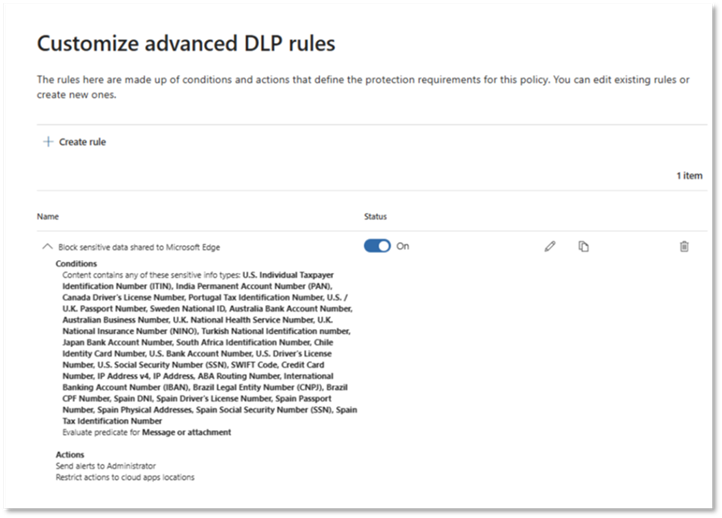

6. De la teoría a la práctica: cuando una interacción de IA es bloqueada

Hasta ahora hemos hablado de visibilidad, postura de seguridad y recomendaciones. Pero la pregunta clave suele ser otra:

¿qué ve realmente el usuario cuando algo no está permitido?

Aquí es donde todo lo anterior cobra sentido.

Imaginemos un escenario muy habitual: un usuario accede desde el navegador a una aplicación de IA, escribe un prompt e incluye información sensible de la empresa. No hay mala intención, simplemente está intentando ser más productivo. Sin embargo, ese contexto no es seguro para compartir ese tipo de datos.

Gracias a la combinación de:

- Sensitive Information Types (SITs)

- Políticas DLP de Microsoft Purview

- Protecciones en navegador

- Y la visibilidad aportada por DSPM for AI

la interacción se evalúa en tiempo real.

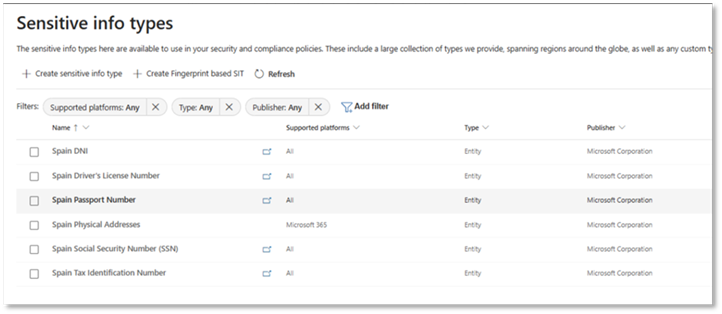

Cuando la política detecta que el contenido del prompt infringe las reglas definidas (por ejemplo, porque contiene datos sensibles), la acción se bloquea automáticamente. El usuario no puede continuar con la interacción y recibe un mensaje claro indicando que ese uso no está permitido.

En esta demo fue necesario incluir en la condición de la directiva, los SITS que referencian a documentos privados de ciudadanos de España, como es el caso de: DNIs, Direcciones postales, números de la seguridad social, etc.

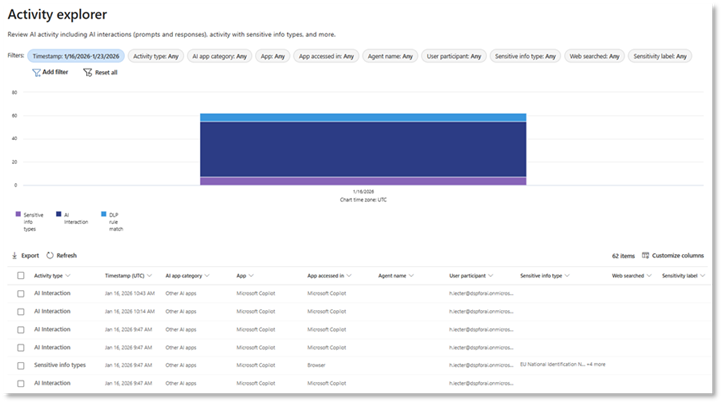

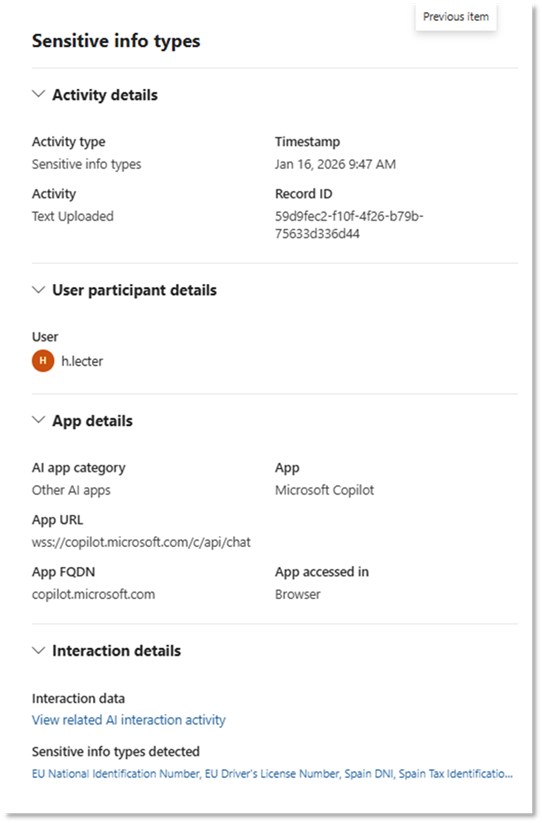

7. Trazabilidad y monitorización: entender qué ocurre después

Bloquear una interacción es importante, pero no suficiente. En escenarios de IA, tan relevante como prevenir una fuga es entender qué está ocurriendo, con qué frecuencia y en qué contexto. Aquí es donde entran en juego la trazabilidad y la monitorización, dos pilares clave del enfoque de DSPM for AI.

Cada interacción evaluada —ya sea permitida, advertida o bloqueada— genera señales que quedan registradas. Esto permite a los equipos de seguridad y cumplimiento responder a preguntas que antes eran muy difíciles de contestar, como:

- ¿Qué tipo de datos sensibles se intentan usar en escenarios de IA?

- ¿Desde qué aplicaciones o servicios ocurre con más frecuencia?

- ¿Es un comportamiento puntual o repetido?

- ¿Afecta a un equipo, a un rol concreto o a toda la organización?

Toda esta información se centraliza en Microsoft Purview, a través del explorador de actividad, lo que facilita no solo la investigación de incidentes, sino también el análisis de tendencias a medio plazo.

Desde un punto de vista operativo, esta trazabilidad permite:

- Ajustar políticas basándose en uso real, no en suposiciones

- Detectar patrones de riesgo antes de que se conviertan en incidentes

- Demostrar cumplimiento ante auditorías o revisiones internas

Además, esta visibilidad continua encaja muy bien con un enfoque de mejora progresiva. No se trata de definir una política “perfecta” desde el primer día, sino de observar cómo se utiliza la IA en la organización y evolucionar los controles en función de ese uso.

En la práctica, la monitorización convierte a DSPM for AI en algo más que un conjunto de reglas: lo transforma en una fuente continua de información para gobernar el uso de la IA de forma responsable.

Deja una respuesta

Lo siento, debes estar conectado para publicar un comentario.