1️⃣ Identidad y acceso: la primera línea de defensa

La Defensa en Profundidad en Azure OpenAI comienza con la identidad. En Azure OpenAI, el acceso se gestiona mediante Microsoft Entra ID, lo que permite aplicar políticas avanzadas de autenticación y privilegios mínimos.

- RBAC (Role-Based Access Control): asigna permisos precisos para evitar accesos innecesarios.

- Privileged Identity Management (PIM): concede privilegios temporales bajo aprobación.

- Autenticación multifactor (MFA): protege cuentas frente a robo de credenciales.

- Managed Identities y tokens de acceso: eliminan el uso de claves embebidas en código.

Aplicar Zero Trust significa verificar cada solicitud, incluso si proviene de un entorno interno. Azure OpenAI debe integrarse en un modelo donde “nada ni nadie se confía por defecto”.

2️⃣ Seguridad de red: aislamiento y control de tráfico

Aunque Azure OpenAI es un servicio público, podemos minimizar la exposición mediante configuraciones de red seguras:

- Private Endpoint: conecta el servicio a la red virtual, evitando salida a Internet.

- Network Security Groups (NSG) + Azure Firewall: controlan flujos y bloquean tráfico no autorizado.

- Azure API Management (APIM): actúa como proxy seguro para gestionar peticiones y aplicar reglas.

- Rate Limiting + WAF: protegen contra abusos y ataques de denegación de servicio.

Estas capas reducen la superficie de ataque y garantizan que solo los canales controlados puedan comunicarse con el servicio de IA.

3️⃣ Protección de datos: confidencialidad e integridad

En proyectos de inteligencia artificial, los datos son el activo más valioso. Implementar controles de protección y gobernanza es fundamental:

- Cifrado de datos en reposo y en tránsito con claves gestionadas por el cliente (CMK).

- Data Loss Prevention (DLP): evita la exposición accidental de información sensible.

- Clasificación y etiquetado mediante Microsoft Purview para aplicar políticas según el nivel de sensibilidad.

- Anonimización y logging responsable en las peticiones a los modelos.

La combinación de cifrado, etiquetado y DLP garantiza que la información procesada por Azure OpenAI cumpla con los estándares de seguridad y privacidad corporativos.

4️⃣ Seguridad en la aplicación: prevención de abusos y mal uso

Los modelos de IA pueden ser objeto de ataques indirectos, como prompt injection o abusos de API. A nivel de aplicación, conviene reforzar las medidas de seguridad con:

- API Keys rotativas y gestión segura de secretos en Azure Key Vault.

- Threat Modeling para identificar riesgos de manipulación o fuga de datos.

- Rate Limiting y validación de entradas de usuario en todas las peticiones.

- Azure Content Safety para filtrar contenidos inapropiados o tóxicos generados por los modelos.

Adoptar controles de seguridad en esta capa evita abusos de las API y reduce la posibilidad de explotación de vulnerabilidades lógicas.

5️⃣ Monitoreo y respuesta a incidentes: detección y acción

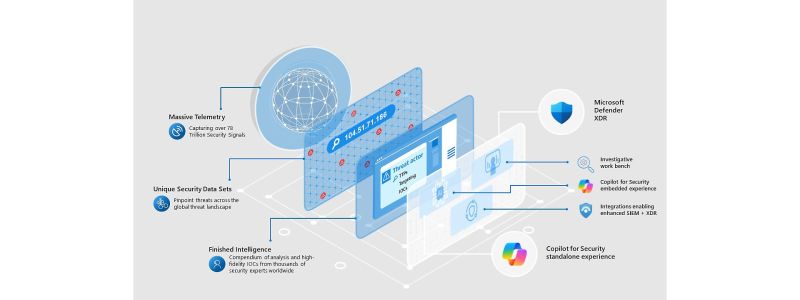

Ninguna estrategia de seguridad está completa sin capacidad de observación y respuesta. En el caso de Azure OpenAI, la integración con las soluciones de seguridad de Microsoft permite detectar y mitigar amenazas de forma proactiva:

- Microsoft Sentinel: correlaciona logs, detecta accesos anómalos y genera alertas automáticas.

- Defender for Cloud: evalúa configuraciones y vulnerabilidades del entorno.

- Alertas de Entra ID y Activity Logs para auditar accesos y cambios.

- Log Analytics centralizado para análisis forense y métricas de uso.

Estas herramientas conforman la capa de detección y respuesta del modelo DiD, cerrando el ciclo con capacidad de reacción rápida ante incidentes.

Una estrategia integral para IA segura

La Defensa en Profundidad en Azure OpenAI no se trata solo de tecnología, sino de adoptar una mentalidad de seguridad en cada capa: verificar identidades, aislar redes, proteger datos, asegurar el código y monitorear constantemente.

En el contexto de la IA generativa, donde los modelos procesan y generan información sensible, este enfoque permite crear un escudo protector multicapa que mitiga riesgos técnicos y éticos.

Recordemos: la pregunta no es si nos atacarán, sino cuándo. Tener cada capa reforzada y conectada entre sí marcará la diferencia entre un incidente controlado o una brecha de seguridad.

Deja una respuesta

Lo siento, debes estar conectado para publicar un comentario.