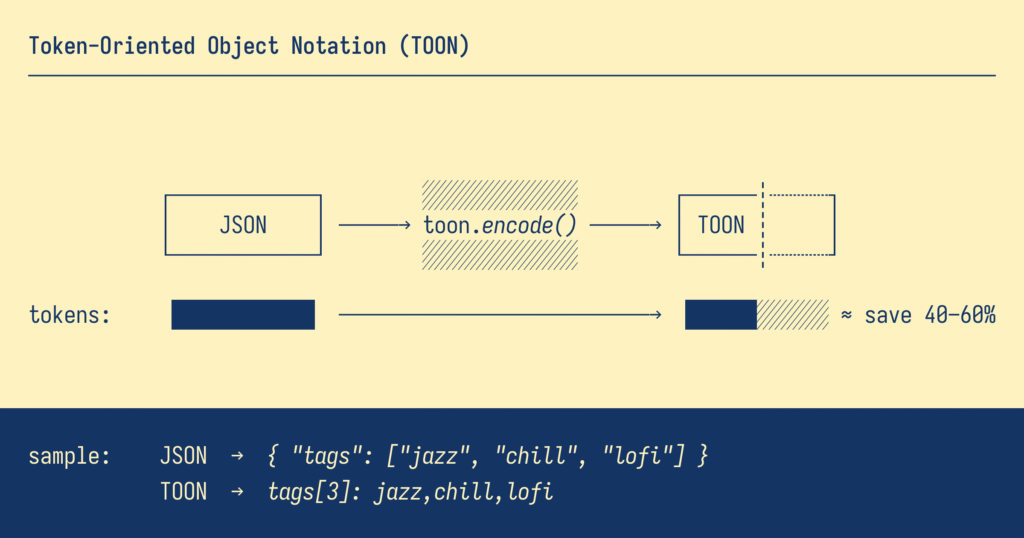

Una notación ligera que puede reducir tus costes en IA hasta un 60 %… sin tocar una sola línea de tu modelo.

Introducción

Cada vez que trabajamos con modelos de lenguaje, pagamos por tokens.

Y no, no hablamos de fichas de casino, sino de cada palabra, coma o símbolo que enviamos a la API.

El problema es que los formatos tradicionales, como JSON, están llenos de ellos.

Cada llave, cada comilla, cada nombre de campo… cuenta. Y cuando multiplicas eso por cientos o miles de llamadas al día, el coste se dispara.

Aquí entra en juego TOON (Token-Oriented Object Notation), una forma más compacta y amigable de enviar datos a los modelos de IA.

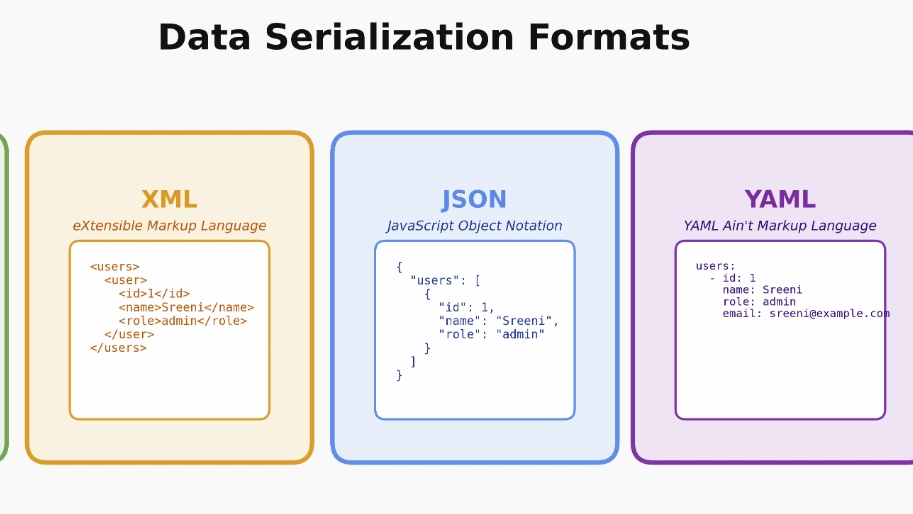

El problema con JSON

JSON ha sido un estándar brillante durante más de 20 años.

Es estructurado, legible y compatible con cualquier lenguaje de programación.

Pero tiene un pequeño gran defecto: es demasiado hablador.

Veamos un ejemplo.

{

"user": "Fernando",

"tasks": [

{ "id": 1, "title": "Analizar datos", "status": "done" },

{ "id": 2, "title": "Generar informe", "status": "pending" }

]

}

Un bloque simple como este puede parecer inofensivo, pero cada palabra dentro de comillas cuenta como un token:

“user”, “title”, “status”… ¡una y otra vez!

TOON al rescate

TOON (Token-Oriented Object Notation) nació precisamente para reducir esa “verborrea” digital.

Su idea es muy sencilla: mantener la estructura de la información, pero sin repetir lo innecesario.

Veamos el mismo ejemplo en formato TOON:

user: Fernando

tasks[id, title, status]:

1, Analizar datos, done

2, Generar informe, pendingMisma información.

Menos ruido.

Y hasta un 45 % menos de tokens.

En modelos que cobran por cada 1.000 tokens (como OpenAI, Anthropic o Gemini), eso puede traducirse en un ahorro real de dinero a fin de mes.

Por qué funciona tan bien

- Define una estructura una sola vez

- En lugar de repetir “title” o “status” en cada línea, los defines al inicio entre corchetes.

- Usa indentación, no símbolos.

- Adiós a las llaves

{}, comillas" "o corchetes[ ].

- Adiós a las llaves

- Es fácil de leer y escribir.

- Incluso alguien sin conocimientos técnicos puede entender qué significa el bloque.

- Reduce tokens sin perder contexto.

- Los modelos de IA entienden TOON como texto natural estructurado.

¿Hay que instalar o configurar algo?

No.

TOON no necesita dependencias ni configuración especial.

No es un lenguaje nuevo, ni una API; es simplemente una forma diferente de escribir tus datos.

Si quieres automatizar la conversión desde Python, puedes hacerlo con unas pocas líneas:

def to_toon(data):

print("tasks[id, title, status]:")

for task in data["tasks"]:

print(f" {task['id']}, {task['title']}, {task['status']}")

to_toon({

"user": "Fernando",

"tasks": [

{"id": 1, "title": "Analizar datos", "status": "done"},

{"id": 2, "title": "Generar informe", "status": "pending"}

]

})Eso es todo.

No hay magia, ni librerías externas. Solo menos tokens y más eficiencia.

¿Los modelos actuales entienden TOON?

Sí.

TOON no es un formato “nuevo” que los modelos deban aprender; es texto estructurado, y los LLMs viven de eso.

Los modelos modernos —como GPT-5, Claude 4, Gemini 2.5 o Llama 4— lo entienden sin problemas si les muestras un ejemplo.

De hecho, basta con incluir una frase en el prompt:

Los datos estarán en formato TOON. Ejemplo:

tareas[id, titulo, estado]:

1, Analizar datos, hecho

2, Generar informe, pendiente

Y listo. El modelo interpretará correctamente el patrón.

¿Afecta al rendimiento?

No negativamente.

Convertir un JSON a TOON es casi instantáneo y, de hecho, el ahorro en tokens puede reducir el tiempo total de inferencia, ya que el modelo procesa menos texto.

En pruebas reales, TOON logra entre un 30 % y un 60 % de ahorro en contextos donde se envían listas u objetos repetitivos (por ejemplo, logs, tareas, inventarios, resultados o pasos de agentes).

Cuándo usar TOON (y cuándo no)

| Usa TOON cuando… | Usa JSON cuando… |

| Trabajas con LLMs (OpenAI, Anthropic, etc.) | Necesitas comunicarte con APIs o bases de datos |

| Quieres ahorrar tokens en flujos repetitivos | Requieres validación formal de datos |

| Envías listas o tablas de objetos | Tienes estructuras muy complejas o anidadas |

TOON en sistemas multiagente

En entornos donde varios agentes se comunican entre sí (como en el Microsoft Agent Framework), TOON es ideal para pasar información estructurada sin aumentar el tamaño del contexto.

Menos tokens entre agentes =

1. más velocidad

2. más contexto útil,

3. y menos coste por interacción.

Conclusión

No hay que ser un experto en IA para entender TOON.

Es una idea simple con un impacto enorme: decir lo mismo, pero con menos ruido.

En un mundo donde los tokens valen dinero, TOON se convierte en una herramienta pequeña, pero muy poderosa.

A veces la mejor optimización no está en el modelo, sino en cómo le hablamos.

¿Tú ya lo estás usando?

Cuéntame en los comentarios cómo optimizas tus prompts o si has probado algún otro formato alternativo.

Deja una respuesta

Lo siento, debes estar conectado para publicar un comentario.